DeepSeek的使用提供了多种方式,即使是小白也可以快速体验,目前主要包括如下三种使用方式:

-

官方提供的DeepSeek服务

-

DeepSeek服务API

-

本地部署DeepSeek大模型

1、使用官方提供的DeepSeek

这种方式最为简单方便,免费,且无需额外的服务资源,适用于大部分人。

网页端

点击如下链接即可在线和DeepSeek对话,如果需要使用DeepSeek-R1模型,则点击选择“深度思考(R1)”即可,如果需要联网搜索你输入问题的相关内容,则点击选择“联网搜索”。

https://chat.deepseek.com/

移动端

扫描如下二维码下载官方APP,注册即可使用。

2、 使用DeepSeek服务API

这种方式则有一定门槛,且需要付费使用,目前有官方API和非官方API两种方式。

DeepSeek官方API

官方API需要在DeepSeek的官网(https://platform.deepseek.com/usage)中申请API服务,不过目前由于官方的服务器资源紧张,暂停了API的申请,需要等待后续通知。

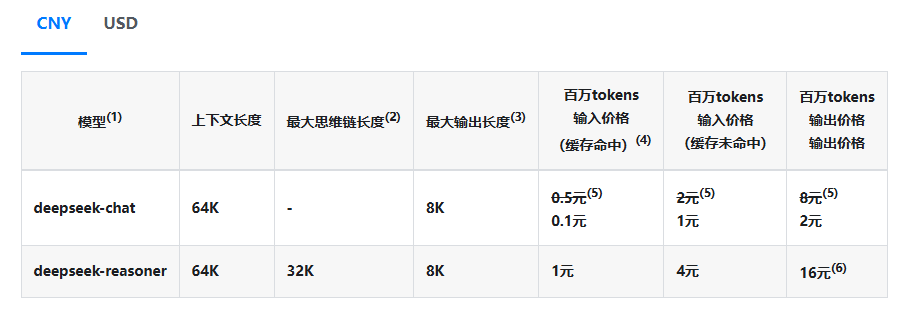

官方的价格说明如下,相对于OpenAI的价格还是良心太多了,基本是便宜5倍以上。

https://api-docs.deepseek.com/zh-cn/quick_start/pricing/

硅基流动平台的API

硅基流动联合华为云推出了基于昇腾云的 DeepSeek R1&V3 推理服务,注册即可申请DeepSeek的V3和R1模型满血版API,而且新注册的用户还赠送了14元的免费额度。

https://cloud.siliconflow.cn/i/Fo8wk304

提供了DeepSeek模型列表如下:

当然也可以在平台上选择DeepSeek模型直接进行对话体验。

安装可视化软件

在有了API之后,如果想要可视化体验DeepSeek等大模型的效果,则需要私有化部署自定义或开源的可视化服务,如Web端或客户端。

客户端软件

客户端软件推荐使用CherryStudio客户端,点击如下链接即可下载安装。安装好之后,在设置中,选择对应的平台,添加平台申请的API密钥,即可在首页的对话框中选择模型进行对话。

https://cherry-ai.com/

Web端

Web端推荐使用LobeChat,开源项目,功能也很强大。

Github地址:https://github.com/lobehub/lobe-chat/blob/main/README.zh-CN.md

可通过多种方式部署:

-

公共的部署平台,如Vercel,步骤参考点击上述Github地址中的Vercel按钮即可部署。

-

本地Docker部署

Docker一键部署的命令如下:

docker run -d -p 3210:3210 \

-e OPENAI_API_KEY=sk-xxxx \

-e ACCESS_CODE=lobe66 \

--name lobe-chat \

lobehub/lobe-chat部署后的首页如下,还有很多更强大的功能等待你去探索。

3、本地部署DeepSeek大模型

如果你想在本地免费使用该模型,则可以考虑使用Ollama安装蒸馏版(即简化版)的DeepSeek大模型,因为满血版的大模型在个人用户机器上部署不起来,需要消耗较多资源。

安装ollama服务

ollama是一个大模型下载和运行的工具,首先需要在点击如下链接下载并安装ollama软件。

https://ollama.com/

启动ollama服务,ollama也提供API调用。

OLLAMA_ORIGINS=* OLLAMA_HOST=0.0.0.0 ollama serve然后在ollama网站上搜索DeepSeek即可看到提供的DeepSeek模型。

选择想要运行的模型,比如deepseek-r1模型,一般选择7B的即可,数字越大,需要消耗的资源越多,然后直接ollama run xxx即可,不过需要先启动ollama服务。

ollama run deepseek-r1可视化页面配置ollama模型

如果想要在可视化页面中使用本地部署的大模型,则需要在可视化页面配置ollama模型的地址。

以LobeChat为例,在设置中找到ollama配置项,然后输入服务地址和端口,并输入本地运行的模型名称,该名字必须和运行的模型名一致,否则会报错。

配置细节可以参考:https://lobehub.com/zh/docs/usage/providers/ollama

配置好之后可以在首页中选择ollama的部署模型。

4、总结

本文总结了三种使用DeepSeek大模型的方式,可以根据各自的需求来选择。如果仅仅是体验功能或日常使用,使用官方提供的网页或APP服务即可,如果需要在其它产品中集成DeepSeek,则需要考虑API的方式。如果对数据隐私有更高的要求,则可以考虑使用第三种的本地私有化部署模式。

评论